Projekt

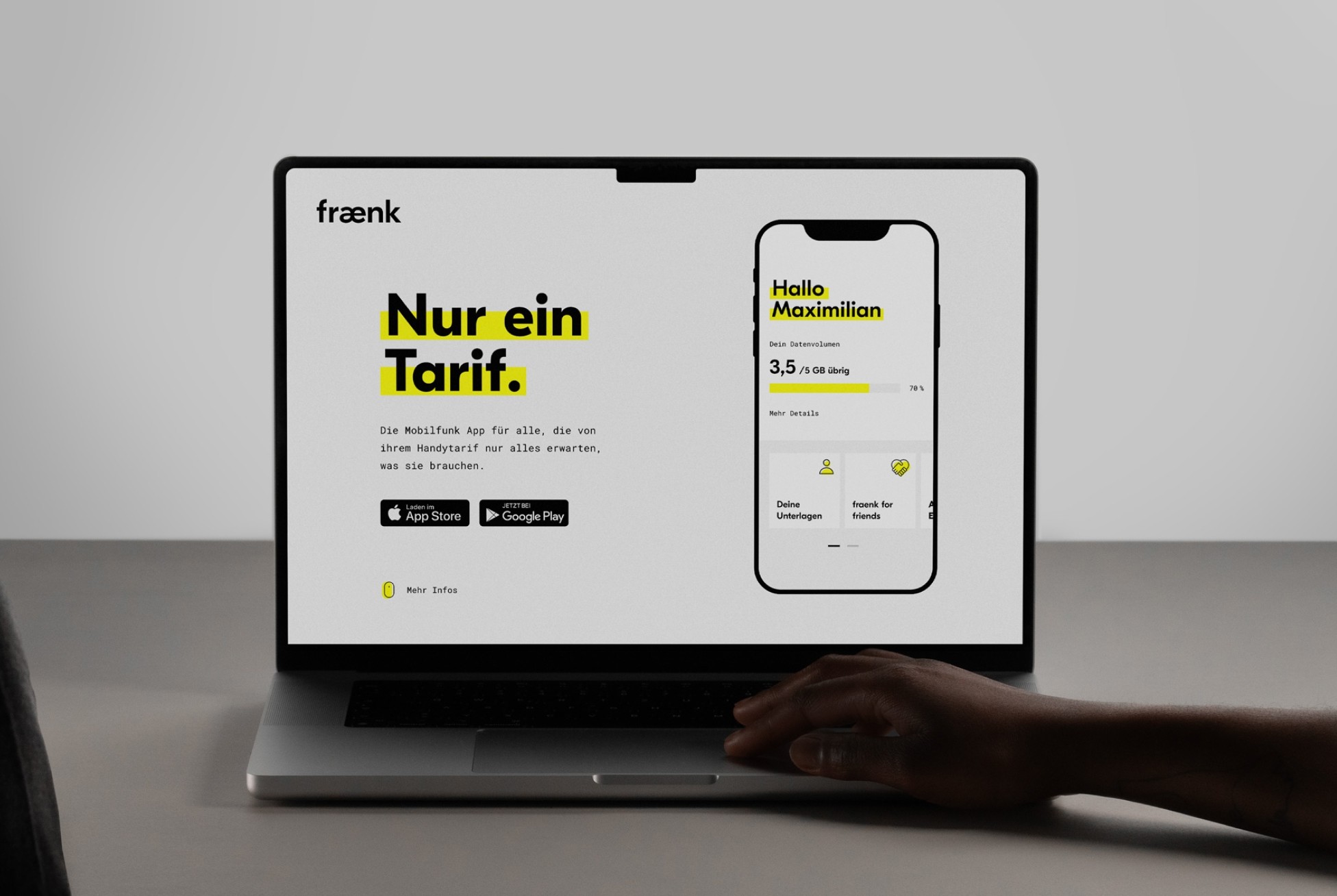

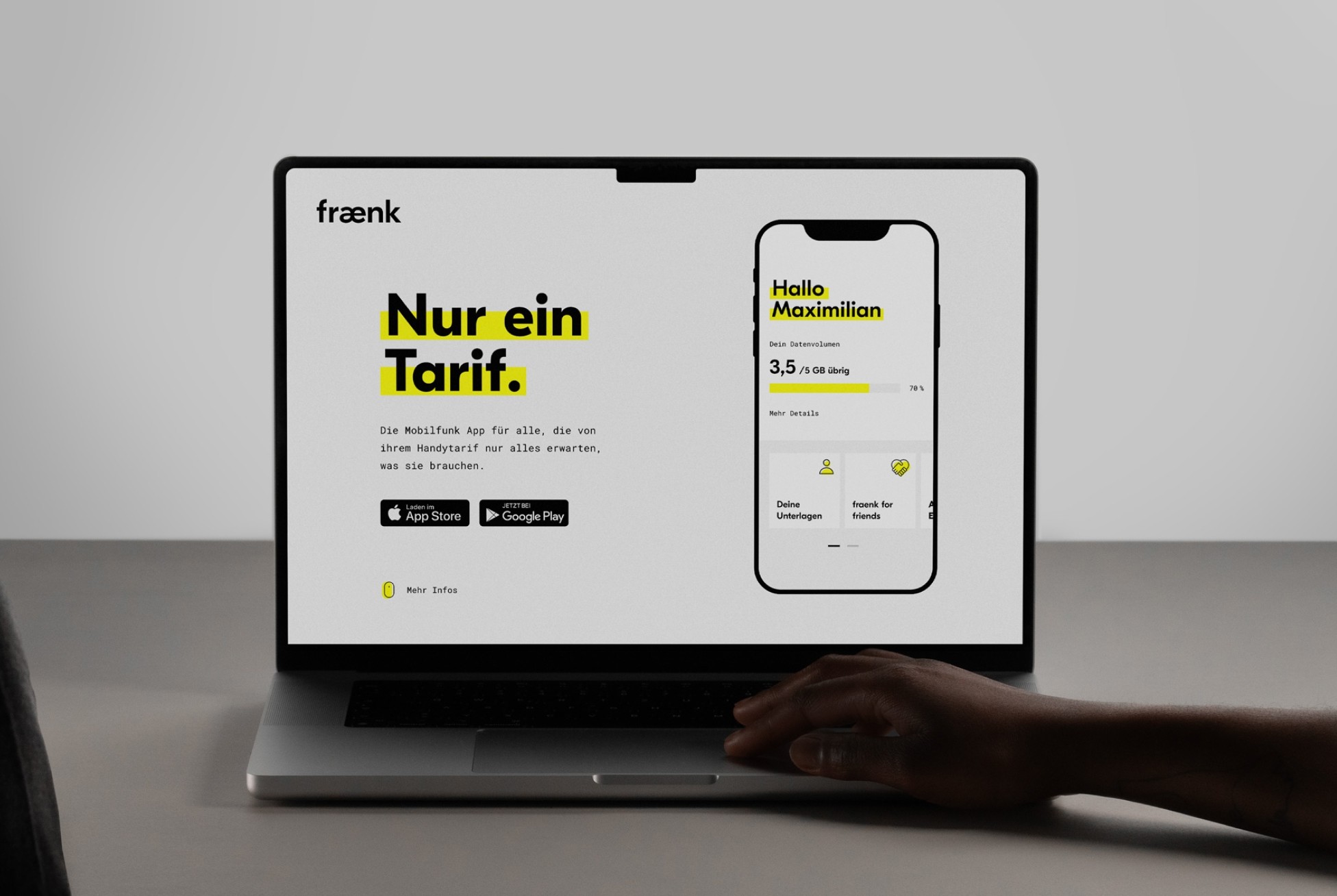

fraenk

Die Mobilfunk App

Für eigentlich jeden Lebensbereich gibt es eine App, die uns den Alltag erleichtert – nur nicht für Handyverträge selbst. Dafür braucht es Websites, Hotlines, Shops, Aufwand und viel Geduld. Wir wurden beauftragt, eine neue Mobilfunkmarke im Discount-Segment zu entwickeln und zu lancieren, die radikal auf Einfachheit setzt: mit einer App, einem Tarif und monatlicher Kündigung. Aber ohne die Vorzüge, die die Konkurrenz stark macht: keine Ladengeschäfte, kein Verkaufspersonal, keine Preisaktionen, keine Tarifoptionen. Wir wollten viel. Wir hatten wenig. Also ließen wir noch mehr weg – alles, was nicht zu einer wirklich guten mobile Experience gehörte. Der daraus resultierende reibungslose und mühelose Service war unsere Wette auf zahlreiche Kundenempfehlungen. Und sie ging auf.

Zitat

„Von der ersten Idee bis zur Brand Story in nur wenigen Wochen! denkwerk hat uns nicht nur bei der Entwicklung der Strategie und des Designs für unsere neue Marke und unser Produkt unterstützt, sondern zeigt auch täglich Begeisterung und Leidenschaft für unsere Marke.“

Katrin Thelen

Brand & Communications Managerin, fraenk

Projekt

fraenk

Die Mobilfunk App

Für eigentlich jeden Lebensbereich gibt es eine App, die uns den Alltag erleichtert – nur nicht für Handyverträge selbst. Dafür braucht es Websites, Hotlines, Shops, Aufwand und viel Geduld. Wir wurden beauftragt, eine neue Mobilfunkmarke im Discount-Segment zu entwickeln und zu lancieren, die radikal auf Einfachheit setzt: mit einer App, einem Tarif und monatlicher Kündigung. Aber ohne die Vorzüge, die die Konkurrenz stark macht: keine Ladengeschäfte, kein Verkaufspersonal, keine Preisaktionen, keine Tarifoptionen. Wir wollten viel. Wir hatten wenig. Also ließen wir noch mehr weg – alles, was nicht zu einer wirklich guten mobile Experience gehörte. Der daraus resultierende reibungslose und mühelose Service war unsere Wette auf zahlreiche Kundenempfehlungen. Und sie ging auf.

Zitat

„Von der ersten Idee bis zur Brand Story in nur wenigen Wochen! denkwerk hat uns nicht nur bei der Entwicklung der Strategie und des Designs für unsere neue Marke und unser Produkt unterstützt, sondern zeigt auch täglich Begeisterung und Leidenschaft für unsere Marke.“

Katrin Thelen

Brand & Communications Managerin, fraenk

Weitere Kunden

Weitere Kunden

Die Fakten

211%

211 % mehr Umsatz erzielten S&P 500-Unternehmen, die eine klare Designorientierung aufweisen.

50%

50 % schnellere Produktentwicklung durch frühes Prototyping.

94%

94 % der ersten Eindrücke sind design-getrieben.

Die Fakten

211%

211 % mehr Umsatz erzielten S&P 500-Unternehmen, die eine klare Designorientierung aufweisen.

50%

50 % schnellere Produktentwicklung durch frühes Prototyping.

94%

94 % der ersten Eindrücke sind design-getrieben.

Die Fakten

211%

211 % mehr Umsatz erzielten S&P 500-Unternehmen, die eine klare Designorientierung aufweisen.

50%

50 % schnellere Produktentwicklung durch frühes Prototyping.

94%

94 % der ersten Eindrücke sind design-getrieben.

Unsere Leistungen

Insight-Driven Ideation

Unser Vorgehen ist human-first. Das heißt, wir beginnen damit, genau zu verstehen, was die Nutzer wollen und brauchen. Anschließend setzen wir diese Erkenntnisse in wirkungsvolle Lösungen um.

Insight-Driven Ideation

Unser Vorgehen ist human-first. Das heißt, wir beginnen damit, genau zu verstehen, was die Nutzer wollen und brauchen. Anschließend setzen wir diese Erkenntnisse in wirkungsvolle Lösungen um.

Insight-Driven Ideation

Unser Vorgehen ist human-first. Das heißt, wir beginnen damit, genau zu verstehen, was die Nutzer wollen und brauchen. Anschließend setzen wir diese Erkenntnisse in wirkungsvolle Lösungen um.

Insight-Driven Ideation

Unser Vorgehen ist human-first. Das heißt, wir beginnen damit, genau zu verstehen, was die Nutzer wollen und brauchen. Anschließend setzen wir diese Erkenntnisse in wirkungsvolle Lösungen um.

Rapid Prototyping

Viele Dinge lassen sich besser erleben als erklären. Wir sind immer bestrebt, Ideen so früh wie möglich zum Leben zu erwecken, für direktes Feedback und kontinuierliche Weiterentwicklung. So gestalten wir nicht nur besser, sondern auch schneller.

Rapid Prototyping

Viele Dinge lassen sich besser erleben als erklären. Wir sind immer bestrebt, Ideen so früh wie möglich zum Leben zu erwecken, für direktes Feedback und kontinuierliche Weiterentwicklung. So gestalten wir nicht nur besser, sondern auch schneller.

Rapid Prototyping

Viele Dinge lassen sich besser erleben als erklären. Wir sind immer bestrebt, Ideen so früh wie möglich zum Leben zu erwecken, für direktes Feedback und kontinuierliche Weiterentwicklung. So gestalten wir nicht nur besser, sondern auch schneller.

Rapid Prototyping

Viele Dinge lassen sich besser erleben als erklären. Wir sind immer bestrebt, Ideen so früh wie möglich zum Leben zu erwecken, für direktes Feedback und kontinuierliche Weiterentwicklung. So gestalten wir nicht nur besser, sondern auch schneller.

Design and Delivery

Von der Idee bis zum fertigen Produkt stellen wir sicher, dass jedes Element auf Kundenbedürfnisse, Markenwerte und Geschäftsanforderungen einzahlt. Wir liefern on strategy, on time und über die Erwartungen hinaus.

Design and Delivery

Von der Idee bis zum fertigen Produkt stellen wir sicher, dass jedes Element auf Kundenbedürfnisse, Markenwerte und Geschäftsanforderungen einzahlt. Wir liefern on strategy, on time und über die Erwartungen hinaus.

Design and Delivery

Von der Idee bis zum fertigen Produkt stellen wir sicher, dass jedes Element auf Kundenbedürfnisse, Markenwerte und Geschäftsanforderungen einzahlt. Wir liefern on strategy, on time und über die Erwartungen hinaus.

Design and Delivery

Von der Idee bis zum fertigen Produkt stellen wir sicher, dass jedes Element auf Kundenbedürfnisse, Markenwerte und Geschäftsanforderungen einzahlt. Wir liefern on strategy, on time und über die Erwartungen hinaus.

Sustainable Growth

Von sich ändernden Kundenbedürfnissen bis hin zu technologischen Möglichkeiten – wir helfen Ihnen dabei, vorauszudenken und dafür zu sorgen, dass Ihr Angebot mit der Zeit geht.

Sustainable Growth

Von sich ändernden Kundenbedürfnissen bis hin zu technologischen Möglichkeiten – wir helfen Ihnen dabei, vorauszudenken und dafür zu sorgen, dass Ihr Angebot mit der Zeit geht.

Sustainable Growth

Von sich ändernden Kundenbedürfnissen bis hin zu technologischen Möglichkeiten – wir helfen Ihnen dabei, vorauszudenken und dafür zu sorgen, dass Ihr Angebot mit der Zeit geht.

Sustainable Growth

Von sich ändernden Kundenbedürfnissen bis hin zu technologischen Möglichkeiten – wir helfen Ihnen dabei, vorauszudenken und dafür zu sorgen, dass Ihr Angebot mit der Zeit geht.

Kontakt

Ready for change?

Wir freuen uns, von Ihnen zu hören.

Ihr Kontakt

José Salam

Client Service Director

Kontakt

Ready for change?

Wir freuen uns, von Ihnen zu hören.

Ihr Kontakt

José Salam

Client Service Director

Kontakt

Ready for change?

Wir freuen uns, von Ihnen zu hören.

Ihr Kontakt

José Salam

Client Service Director

Kontakt

Ready for change?

Wir freuen uns, von Ihnen zu hören.

Ihr Kontakt

José Salam

Client Service Director

Scroll to explore